Nello sviluppare una serie di test orientati alla link building piuttosto estesi e corposi, mi sono imbattuto nella presenza costante di 2 grandi anomalie sul posizionamento organico.

Ho sintetizzato queste anomalie con due termini ovvero Google Ranking Cap e Profilo di Link Building e cerco ora di spiegarvi e dimostrarvi come questi elementi nascondano il segreto portante del posizionamento su Google.

So che questo post risulterà molto controverso, poco comprensibile o frutto di droghe pesanti secondo il pensiero della maggior parte dei lettori; tuttavia abbiate fede e un giorno o l'altro avrete le risposte :D

Partiamo con il concetto di Google Ranking Cap.

Chiunque abbia un sito e lavori per la sua ottimizzazione e per il posizionamento, avrà notato che ad un certo punto per quanto si incrementino link e pagine, la linea di traffico organico appare come una linea retta, al netto di variazioni stagionali.

Anche potenziando l'ottimizzazione delle pagine marginali e tentando il recupero delle pagine meno posizionate, il risultato alla fine non cambia. Allo stesso modo, incrementando le pagine non si crea una variazione positiva di traffico.

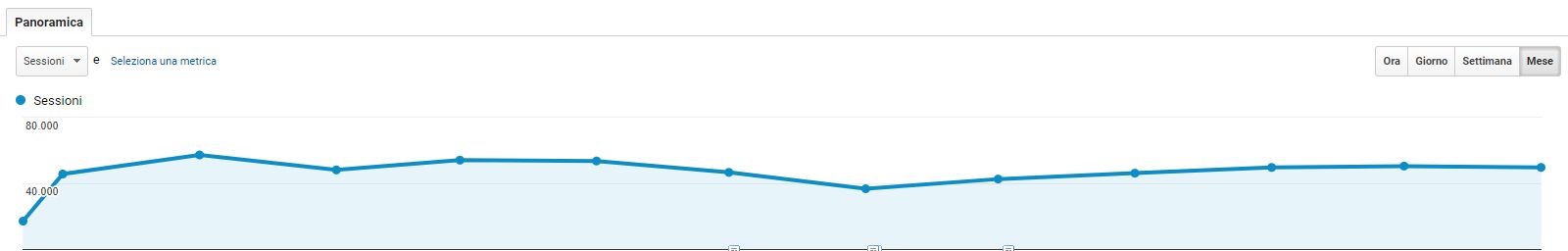

Vi mostro ora alcuni grafici di siti ben ottimizzati e spinti praticamente al massimo. Parliamo di siti da 5-10-30 mila visite organiche giornaliere in base ai diversi settori.

(Aprite le immagine in nuova finestra per zoom)

Esempio 1

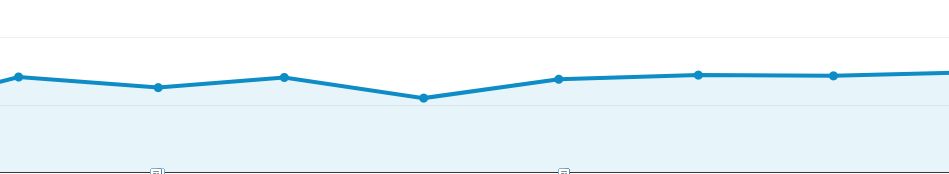

Esempio 2

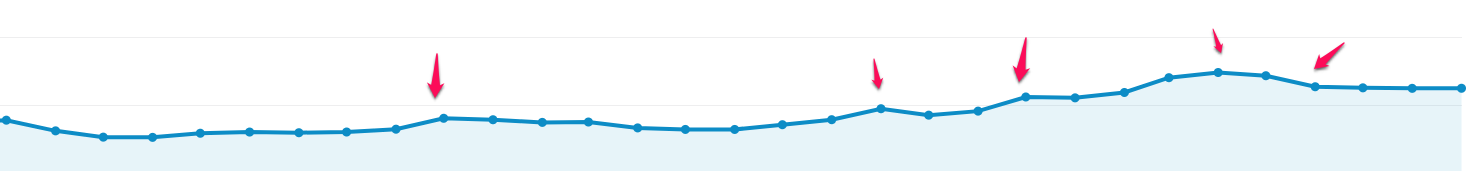

Esempio 3

Per quanto si tenti di spingere ulteriormente il posizionamento, l'analisi dei ranking cosi come del traffico evidenzia che il risultato non si smuove da un valore medio.

Questo fenomeno che ho chiamato Google Ranking Cap è una delle principali variabili nell'equazione SEO che di fatto stabilisce il limite di visibilità organica di un determinato sito.

E' una variabile importante che di fatto evita che un qualuqne sito possa cannibalizzare l'intero web sfruttando trust e sviluppo di contenuti. Senza questa garanzia, un sito ad alto trust e una buona e costante produzione di contenuti, potrebbe in poco tempo imporsi per qualunque genere di parole chiave.

Per quanto Google abbia sempre negato l'esistenza di un Ranking Cap, questo fenomeno è ampiamente dimostrabile nei fatti guardando ranking e soprattutto linea di traffico organica. Moltissimi forum BlackHAT trattano l'argomento.

Il valore di Ranking Cap è un valore che dipende da diverse variabili e dove il potenziale di backlink vale almeno il 70% di questo ipotetico valore. Il Ranking Cap esiste fin dalla stessa registrazione del dominio.

Man mano che incrementiamo questo valore, aumentiamo il numero di pagine non tanto indicizzate ma posizionate.

Il Ranking Cap si manifesta in un sito web anche mediante la tipica crescita a scalino.

Ad un certo punto dello storia, un sito web che ha fatto sempre 100 visite al giorno, scala per esempio a 150 e continua a generare 150 visite per un tempo indefinito. Successivamente, scala ulteriormente aumetando di volta in volta questo scalino.

Per quanto le grandi corazzate SEO sviluppino continuamente link e contenuti, il loro posizionamento e traffico organico non cresce di pari passo; anzi. Laddove i siti guadagnano, lasciano scoperte alcune aree e permettono a siti decisamente meno trust di posizionarsi.

Chiunque abbia gestito un sito di grandi dimensioni, ad ogni incremento di potenziale seo, contenuti o link vede sul proprio ranking di controllo migliaia di chiavi in salita e altrettante migliaia in discesa. Per quanto ci si possa sbattare testa e mani, il risultato globale in termini di traffico non cambia. Molto spesso, interi reparti crollano in termini di visibilità a favore di altri (e questo Amazon ed Ebay lo conoscono bene).

Ho voluto giocare con Google e questo fenomeno con questo risultato.

Ogni scalino incrementa il limite di traffico. Potete vedere gli effetti su un sito web esistente da diversi anni. Nonostante anni e anni di pubblicazioni e migliaia di post presenti online, il sito web non schiodava il traffico da poche centinaia di visite settimanali.

Agendo sul Ranking Cap e studiando i fenomeni di NON posizionamento presenti, ovvero elementi che costituiscono le anomalie, è stato possibile sbloccare mese dopo mese il traffico agendo con interventi mirati e specifici.

A parità di contenuto, oggi lo stesso sito web genera oltre 250.000 visite organiche mensili.

In questo altro esempio, vediamo l'effetto dello scalino sia in crescita che in riduzione. Come vedete, a seguito di una riduzione di Ranking Cap il traffico è scalato e si è ri-allineato su linea quasi perfettamente retta.

La seconda anomalia, che ho chiamato Profilo di Backlink, è molto più delicata.

Secondo la teoria classica SEO, i backlink acquisiti determinano secondo dei principi diversi il trust di un sito web. Questa serie di regole e principi, permette a Google di stabilire che un determinato sito, per esempio Repubblica, sia più autorevole di un piccolo quotidiano di provincia.

Secondo questo principio, tanto più è elevato il trust di un sito web, tanto più questo sarà avvantaggiato in ottica organica. E' un fenomeno che sicuramente avrete notato nelle SERP ogni qualvolta trovate un sito posizionato al top per una specifica parola chiave nonostante il sito non sia per nulla ottimizzato per quel tipo di ricerca.

Questo fenomeno, come quello precedente, ha però una regola di salvacondotta. E' una regola inserita che di fatto evita che un sito ad altissimo potenziale SEO, come per esempio potrebbe essere il sito di Apple, possa comunque posizionarsi per qualunque parola chiave.

Senza questo sistema di controllo, ad Apple basterebbe inserire una pagina mediamente ottimizzata per esempio per Hotel Roma per potersi posizionare senza problemi, potendo contare su un trust altissimo. O peggio ancora: se Apple generasse milioni di pagine di contenuto, potrebbe in poco tempo guadagnare milioni di visite organiche.

Al tempo stesso, se gestite un sito da molti anni e avete lavorato per accrescrere il vostro trust (o più semplicemente lavorate su uno dei siti più importanti del vostro settore), avrete notato che di frequente siti nuovi o relativamente nuovi riescano a posizionarsi meglio di voi.

Secondo la teoria classica, un sito nato da pochi mesi non potrebbe mai superare in termini di trust un sito che esiste da decenni.

Al tempo stesso, un sito che esiste da molti anni avrebbe sempre un vantaggio numerico rispetto ad un sito più recente.

Nessun sito di nuova ideazione potrebbe in pochi mesi guadagnare quantità e qualità di link guadagnati magari da un concorrente online da 5-10-20 anni.

Questo porterebbe nel giro di poco tempo, ad una completa stratificazione delle SERP, impendendo a qualunque nuovo sito web di entrare nelle posizioni che contano, acquisire traffico e quindi crescere.

Queste anomalie sono riscontrabili in situazioni di quasi monopolio come per esempio quelle create sul segmento ricette da Giallo Zafferano, da Aranzulla nelle guide tech o Booking nel segmento Hotel.

Com'è possibile questo?

In realtà, sempre gestendo alcuni test in ottica SEO, ho testato e dimostrato che anche con pochi link sia possibile guadagnare ottime posizioni e scalzare cosi concorrenti online da moltissimi anni.

Dai test effettuati, sono riuscito a posizionare alcuni dei peggggiori siti web di Caracas fino all top 3 su parole chiave piuttosto competitive per esempio su serp finanziarie. Tutto questo sfruttando pochissimi link e nonostante contenuti della peggiore specie.

Per fare un esempio, provate ad analizzare finanza24ore.net.

Ho tralasciato parola chiavi improbabili o impossibili a livello SEO e ho puntato su una serie di 4 parole con una buona concorrenza.

Pochi contenuti, una singola pagina sviluppata in meno di 5 minuti. Pochissimi link e qualche directory. Tutte premesse che dovrebbero portare ad un nulla di fatto.

Eppure, questo infimo sito web si posiziona per lo più in top 3 o top 5.

Guida agli investimenti in borsa 3

Guida agli investimenti in titoli 1

Guida agli investimenti in azioni 3

Guida agli investimenti in obbligazioni 6

Le parole chiave non sono impossibili, è vero, ma pensa che tutto questo è stato ottenuto con qualche link che molti definirebbero spazzatura e i peggiori contenuti mai prodotti dalla mia mente.

Perchè è stato possibile?

Per garantire un ricambio delle pagine web e favorire al tempo stesso nuovi contenuti, Google deve aver introdotto una regola di salvacondotta per permettere alle nuove pagine web di emergere ed essere cosi visualizzate dagli utenti.

Per fare questo, ha creato qualcosa che io ho chiamato Profilo di Backlink, che è una sorta di password che consentirebbe a qualunque progetto web di acquisire velocemente visibilità.

Questa password è costituita da un pattern di backlink che, se indovinata, permettono ad una qualunque pagina web di posizionarsi anche su temi molto caldi e complessi.

Il pattern è semplicemente l'insieme di link che una entità web potrebbe acquisire in modo spontaneo.

Tutti i seo del mondo parlano di acquisire link ad elevato trust. Tutti sognano di apparire su Repubblica o Sole 24 ore ma la realtà è che un sito web vero, guadagna in misura maggiore più link spazzatura che link ad alto trust.

Ecco che un sito web spinto unicamente da siti di ottimo livello appare sicuramente fuori standard.

Ho voluto ripetere questo test con diversi siti che disponevano di profili di backlink da domini con ottimo trust inserendo link spazzatura.

Questi i risultati ottenuti.

Da questi test provati e riprovati decine e decine di volte, ho evidenziato come il Profilo di Backlink dipenda da 3 elementi diversi ovvero link, tipologia di link e modalità e tempo di acquisizione.

Prendendo un qualunque sito web e schematizzando il profilo di backlink è possibile capire che tipo di link serva.

In molti casi, soprattutto su siti gestiti da SEO, qualche link spazzatura potrebbe essere ampiamente sufficiente.

Di questa formula:

Profilo BackLink + Seo on-page + Variabile da Scoprire = Google Ranking Cap

sto analizzando i diversi fattori.

Per quanto riguarda la prima variabile, sono giunto a questa conclusione:

Qualità BackLink + Tipologia di Link + Modalità di Acquisizione = Profilo BackLink

Nei test sopra indicati ho mantenuto la ratio di qualità 70 scarso /20 medio /10 ottimi.

In ottica di tipologia di link, 90 non anchor, 10 anchor.

In ottica di modalità di acquisizione, 40 in text, 30 link, 30 altro.

La questione Content e Ottimizzazione è stata più volte analizzata e testata da milioni di test svolti da SEO in tutto il mondo e non serve aggiungere altro.

Resta da comprendere quale o quali elementi generano le anomalie inizialmente descritte.

Mi occupo di SEO e Lead Generation. Sono appassionato di tecnologia e innovazione e fondatore di alcune importanti testate hi-tech. Attualmente CoFounder e Seo Manager presso Omniaweb, Cofoudner Tag Padova, Hostplace.